Spis treści

Co to jest budowa procesora?

Struktura wewnętrzna procesora, czyli CPU, ma ogromne znaczenie dla jego efektywności, zużycia energii oraz zdolności obliczeniowych. Procesor zbudowany jest z wielu elementów, w tym:

- rdzeni,

- pamięci podręcznej,

- jednostek arytmetyczno-logicznych (ALU),

- jednostek obliczeniowych zmiennopozycyjnych (FPU),

- rejestrów,

- układów sterowania,

- magistral.

To rdzenie wykonują polecenia; im ich więcej, tym lepiej procesor radzi sobie z równoległym przetwarzaniem, co przekłada się na wyższą wydajność. Pamięć podręczna odgrywa kluczową rolę, przechowując często wykorzystywane dane, co znacznie przyspiesza dostęp w porównaniu do pamięci RAM. ALU wykonuje operacje arytmetyczne i logiczne, podczas gdy FPU zajmuje się obliczeniami związanymi z liczbami zmiennoprzecinkowymi. Rejestry pełnią funkcję szybkiej pamięci, przechowując dane tymczasowe oraz wyniki obliczeń. Dodatkowo, układ cyfrowy koordynuje komunikację pomiędzy różnymi komponentami, a magistrale odpowiadają za transfer danych do innych części systemu.

Warto również zwrócić uwagę na warstwy półprzewodnikowe oraz monokryształ krzemu, które są kluczowe w konstrukcji procesora, ponieważ decydują o jego właściwościach elektrycznych i efektywności energetycznej. Proces technologiczny, w jakim tworzone są obwody, także ma znaczący wpływ na parametry samego procesora. Te wszystkie elementy wskazują, jak istotna jest wewnętrzna budowa procesora w kontekście nowoczesnej technologii komputerowej.

Jak architektura procesora definiuje jego komponenty?

Architektura procesora to fundamentalna struktura, która definiuje organizację kluczowych funkcji, składających się na działanie procesora. Zalicza się do niej między innymi:

- liczba rdzeni,

- sposób, w jaki zorganizowana jest pamięć podręczna,

- różne typy jednostek wykonawczych, w tym jednostki arytmetyczno-logiczne (ALU),

- jednostki obliczeniowe zmiennopozycyjne (FPU).

To, jak zaprojektowana jest architektura, ma wpływ na:

- magistrale,

- kontrolery pamięci (MMU),

- jednostki sprzężenia z magistralą (BIU).

Na przykład klasyczna architektura von Neumanna posiada jeden wspólny strumień dla danych i instrukcji. W przeciwieństwie do niej, architektura harwardzka oddziela te dwa strumienie, co wpływa na:

- wydajność procesora,

- możliwości równoległego przetwarzania.

Ponadto, zarządzanie pamięcią i metody adresowania, które wynikają z architektury, determinują sposób realizacji instrukcji oraz współpracę z innymi elementami systemu. Dlatego kluczowe jest dokonanie właściwego wyboru architektury, co przekłada się na efektywność energetyczną i wydajność obliczeń. Jest to szczególnie istotne w kontekście dzisiejszych wielordzeniowych procesorów, gdzie równoległość obliczeń ma kluczowe znaczenie dla optymalizacji ich pracy.

Jakie są główne elementy budowy procesora?

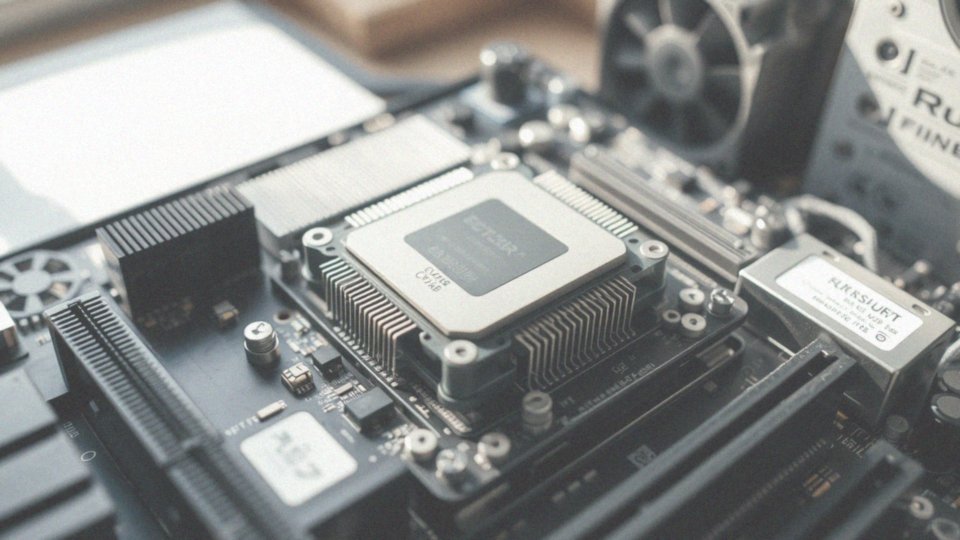

W sercu każdego procesora znajdują się kluczowe bloki funkcjonalne, które tworzą jego strukturę. Na czoło wysuwa się jednostka sterująca, która organizuje przepływ danych oraz instrukcji, decydując, w jakiej kolejności powinny być one realizowane. Równolegle działa jednostka arytmetyczno-logiczna (ALU), odpowiedzialna za wykonywanie różnorodnych operacji matematycznych i logicznych, co jest nieodłącznym elementem przetwarzania informacji.

Aby przechowywać aktualne dane, procesor wykorzystuje rejestry, które pełnią rolę tymczasowej pamięci. W kontekście przyspieszania pracy, pamięć podręczna (cache) odgrywa istotną rolę jako rodzaj bufora pomiędzy procesorem a pamięcią RAM, co znacznie przyspiesza dostęp do najbardziej wykorzystywanych informacji.

Z kolei jednostka zarządzania pamięcią (MMU) czuwa nad dostępem do pamięci RAM, zapewniając integralność danych oraz efektywnie zarządzając ich lokalizacją. Nie można zapomnieć o dodatkowych elementach:

- jednostka pobierająca instrukcje,

- blok dekodowania.

Ich zadaniem jest ładowanie i interpretacja poleceń z pamięci. Jednostka wykonawcza jest odpowiedzialna za realizację wszystkich obliczeń, natomiast magistrale, działające jako interfejs komunikacyjny między poszczególnymi komponentami, umożliwiają transfer danych. Cała architektura procesora, obejmująca te różnorodne elementy, jest kluczowa dla jego wydajności oraz możliwości obliczeniowych. Odpowiednia kombinacja tych składników gwarantuje sprawne i efektywne działanie całego systemu komputerowego.

Jakie są główne rodzaje jednostek sterujących w procesorze?

Jednostki sterujące w procesorze mają kluczowe znaczenie dla jego efektywności i prawidłowego działania. W ich skład wchodzi szereg istotnych komponentów, w tym:

- układ sekwencjonowania mikroinstrukcji,

- dekoder rozkazów,

- generator sygnałów sterujących,

- jednostka zarządzania przerwaniami,

- układ sterowania oraz synchronizacji.

Układ sekwencjonowania mikroinstrukcji generuje mikrooperacje, które są niezbędne do realizacji instrukcji maszynowych. Działa na podstawie kodu operacji, co umożliwia synchronizację oraz kontrolę procesów zachodzących w procesorze. Dekoder rozkazów interpretuje instrukcje oraz przekształca je w sygnały sterujące, aktywujące odpowiednie bloki funkcjonalne i umożliwiające wykonanie zadań. Po przetworzeniu każda instrukcja przechodzi przez fazy pobierania i wykonania – to kluczowe kroki, które zapewniają sprawne funkcjonowanie systemu. Wszystkie procesy upłynniają sygnały generowane przez generator sygnałów sterujących, który synchronizuje działanie komponentów procesora, zapobiegając w ten sposób konfliktom i błędom. Ponadto, jednostka zarządzania przerwaniami monitoruje sygnały z urządzeń zewnętrznych, co pozwala procesorowi na asynchroniczne reagowanie na zdarzenia zachodzące w systemie. Układ sterowania oraz synchronizacji ma również wpływ na generację sygnałów taktujących, które synchronizują operacje wewnętrzne procesora. Wspólna praca tych jednostek tworzy zintegrowany system sterowania i synchronizacji, fundamentalny dla wydajności całego procesora. Ich prawidłowe działanie ma ogromne znaczenie dla efektywnego realizowania instrukcji, co z kolei wpływa na architekturę komputera i jego całkowite możliwości obliczeniowe. Dzięki zrozumieniu funkcji tych komponentów można lepiej przybliżyć, jak procesory przetwarzają dane i wykonują skomplikowane operacje.

Jakie funkcje pełni jednostka arytmetyczno-logiczna (ALU)?

Jednostka arytmetyczno-logiczna, znana jako ALU, odgrywa fundamentalną rolę w architekturze procesora. To dzięki niej realizowane są zarówno operacje arytmetyczne, jak i logiczne, stanowiące fundament obliczeń w komputerach. ALU wykonuje różnorodne działania, w tym:

- dodawanie,

- odejmowanie,

- mnożenie,

- dzielenie,

- operacje logiczne takie jak AND, OR, NOT czy XOR.

Podczas przetwarzania informacji korzysta z danych z rejestrów i pamięci, co pozwala na elastyczne i dynamiczne działanie. Wyniki obliczeń trafiają do rejestrów, co zapewnia ich szybki dostęp w kolejnych etapach pracy procesora. Dodatkowo, ALU generuje sygnały znaczników, które informują o aktualnym stanie operacji, na przykład wskazując, czy zaszło przekroczenie zakresu lub czy wynik jest równy zeru. Te dane są kluczowe dla kontynuacji przetwarzania. Kod operacji, który ALU tłumaczy, określa, jakie konkretne obliczenia mają zostać zrealizowane, co czyni ją istotnym elementem jednostki wykonawczej procesora. Odpowiada za realizację różnorodnych operacji obliczeniowych, a jej wydajność jest kluczowa dla działania całego systemu komputerowego. Można zauważyć, że ALU ma ogromne znaczenie w grach komputerowych, programach inżynieryjnych czy algorytmach kryptograficznych, gdzie szybkość i precyzja obliczeń w dużej mierze decydują o efektywności.

W jaki sposób rejestry procesora wpływają na jego działanie?

Rejestry procesora są niezwykle ważnym elementem jego funkcjonowania. Działają jak szybka pamięć, która gromadzi zarówno dane, jak i adresy pamięci czy wyniki obliczeń. Dzięki temu dostęp do informacji jest znacznie szybszy w porównaniu z pamięcią RAM, co pozytywnie wpływa na wydajność całego systemu.

Istnieje kilka rodzajów rejestrów, z których każdy ma przypisane określone zadania:

- rejestr rozkazów (PC) przechowuje adres kolejnej instrukcji do realizacji,

- akumulator pełni rolę w obliczeniach arytmetycznych oraz logicznych, przechowując ich wyniki,

- rejestr znaczników informuje o stanie operacji, na przykład czy wynik był równy zero, lub czy wystąpiło przepełnienie.

Rejestry mają znaczący wpływ na efektywność procesora, ponieważ ograniczają konieczność częstego dostępu do pamięci operacyjnej. Umożliwia to procesorowi sprawniejsze przeprowadzanie obliczeń oraz realizowanie bardziej skomplikowanych zadań.

To, jak zorganizowane są rejestry i ich architektura, determinuje sposób adresowania danych, co również wpływa na wydajność systemu. Liczba oraz struktura rejestrów mają kluczowe znaczenie dla możliwości równoległego przetwarzania danych. A to z kolei prowadzi do lepszego wykorzystania zasobów dostępnych w systemie. Odpowiednio zaprojektowane rejestry znacząco zwiększają moc obliczeniową procesora, co jest niezwykle istotne w dzisiejszych nowoczesnych systemach komputerowych.

Jakie znaczenie ma pamięć podręczna w budowie procesora?

Pamięć podręczna, znana również jako cache, odgrywa kluczową rolę w architekturze procesora. Jest to szybki typ pamięci o ograniczonej pojemności, ulokowany blisko rdzeni procesora, co umożliwia natychmiastowy dostęp do danych oraz instrukcji. Dzięki temu, czas dostępu do informacji jest znacznie krótszy w porównaniu do pamięci RAM, co przekłada się na wyższą wydajność całego systemu komputerowego.

Cache dzieli się na różne poziomy, takie jak:

- L1 – najszybszy, pojemność od 16 KB do 64 KB na rdzeń,

- L2 – większa pojemność, sięgająca od 256 KB do 512 KB,

- L3 – od 1 MB do nawet 8 MB lub więcej.

Taka hierarchia pamięci jest niezwykle istotna, ponieważ cache przechowuje najczęściej używane dane, co znacznie przyspiesza procesy obliczeniowe. Dzięki zastosowaniu pamięci podręcznej, opóźnienia wynikające z dostępu do pamięci operacyjnej są znacznie zredukowane. W szczególności w grach komputerowych oraz aplikacjach inżynieryjnych, gdzie wymagana jest szybka reakcja, jest to niezwykle ważne. Skuteczne zarządzanie pamięcią podręczną ma zatem ogromny wpływ na efektywność procesora i całego systemu komputerowego. Bez odpowiednio zorganizowanej pamięci podręcznej, praca procesora mogłaby znacznie zwolnić, co negatywnie odbiłoby się na wydajności obliczeń.

Jak budowa procesora wpływa na wydajność obliczeń?

Budowa procesora ma istotny wpływ na jego wydajność w obliczeniach. Wśród najważniejszych elementów znajdują się:

- liczba rdzeni,

- częstotliwość taktowania,

- organizacja pamięci podręcznej,

- architektura.

Procesory wielordzeniowe, posiadające od 2 do 128 rdzeni, potrafią równolegle obsługiwać wiele wątków, co znacząco zwiększa efektywność w wymagających zadaniach, takich jak renderowanie grafiki 3D czy analiza rozległych zbiorów danych. Częstotliwość taktowania, wyrażana w GHz, informuje o liczbie cykli realizowanych przez procesor w sekundy. Procesory o przekroczonej częstotliwości 5 GHz są w stanie przetwarzać więcej instrukcji, co bezpośrednio przekłada się na lepszą wydajność. Z kolei pamięć podręczna, podzielona na poziomy L1, L2 i L3, umożliwia szybki dostęp do często wykorzystywanych danych. Im większa pamięć cache, tym krótszy czas oczekiwania na dane z pamięci RAM, co skutkuje płynniejszym działaniem aplikacji.

Architektura jednostek arytmetyczno-logicznych (ALU) oraz jednostek obliczeniowych zmiennopozycyjnych (FPU), a także techniki takie jak potokowość i superskalarność, pozwalają na jednoczesne realizowanie wielu instrukcji. Dzięki tym innowacjom procesory skuteczniej wykorzystują swój czas obliczeniowy. Nie można również zapominać o znaczeniu procesu technologicznego w produkcji procesorów, który ma ogromny wpływ na ich ogólną wydajność. Wykorzystanie nowoczesnych technologii, jak litografia 7 nm, poprawia efektywność energetyczną oraz inne parametry, co jest szczególnie istotne dla długoterminowego działania komputerów.

W jaki sposób wielordzeniowość wspomaga równoległość obliczeń?

Wielordzeniowość odgrywa kluczową rolę w umożliwianiu równoległego przetwarzania obliczeń. Procesory, które dysponują kilkoma niezależnymi rdzeniami, są w stanie jednocześnie realizować różne strumienie instrukcji. Taki układ umożliwia równoległe wykonywanie wielu zadań, co znacznie podnosi moc obliczeniową całego systemu.

Gdy system operacyjny oraz aplikacje zostały zaprojektowane z myślą o dzieleniu zadań na mniejsze fragmenty, każdy rdzeń może zająć się osobnym wątkiem do przetworzenia, co prowadzi do efektywniejszego wykorzystania zasobów obliczeniowych. Dodatkowo, technika hyper-threading pozwala na emulację dwóch logicznych rdzeni dla każdego fizycznego rdzenia, co jeszcze bardziej wzmacnia możliwości równoległego przetwarzania.

W praktyce oznacza to, że programy, które operują w trybie wielowątkowym, takie jak aplikacje do edycji wideo czy nowoczesne gry komputerowe, mogą w pełni wykorzystywać potencjał procesorów wielordzeniowych, co przyczynia się do maksymalizacji ich wydajności. Dlatego też, wielordzeniowość staje się nieodzownym elementem w złożonych obliczeniach, gdzie efektywne przetwarzanie równoległe jest kluczowe dla optymalizacji zasobów systemowych.

Jakie są różnice między różnymi architekturami procesorów?

Zrozumienie różnic pomiędzy architekturami procesorów jest kluczowe, aby ocenić ich wydajność i zastosowania. Wyróżniamy dwa główne typy architektur:

- CISC (Complex Instruction Set Computing),

- RISC (Reduced Instruction Set Computing).

Procesory CISC, takie jak x86, charakteryzują się rozbudowanym zestawem instrukcji, co pozwala na realizację skomplikowanych operacji za pomocą pojedynczego polecenia. Z kolei RISC uproszcza ten zestaw, co sprzyja szybszemu wykonaniu podstawowych zadań; dobrym przykładem jest architektura ARM. Nie można także zapominać o architekturze przetwarzania, takiej jak:

- Von Neumann,

- Harvard.

Obie mają znaczący wpływ na organizację pamięci. W architekturze Von Neumanna zarówno dane, jak i instrukcje dzielą tę samą przestrzeń pamięci, co może prowadzić do problemów z dostępem. Natomiast Harvard oddziela pamięć dla danych i instrukcji, co zwiększa przepustowość i efektywność operacji. W dobie wielordzeniowości nowoczesne procesory są projektowane z myślą o obsłudze wielu rdzeni, co umożliwia równoległe przetwarzanie różnych zadań. Taki układ sprzyja lepszemu wykorzystaniu mocy obliczeniowej oraz przyspiesza przetwarzanie informacji. Kolejnym istotnym elementem jest pamięć podręczna, która różni się ilością oraz typem cache (L1, L2, L3), co w znacznym stopniu wpływa na prędkość dostępu do najczęściej używanych danych. Rozmiar i organizacja pamięci podręcznej mają kluczowe znaczenie w aplikacjach wymagających dużej mocy obliczeniowej. Nowoczesne procesory wykorzystują innowacyjne techniki potokowe oraz superskalarny design, co pozwala na jednoczesne wykonywanie wielu instrukcji, zwiększając tym samym ich efektywność. Różnorodność metod adresowania dodatkowo wpływa na sposób, w jaki operacje są realizowane. Dlatego dokonując wyboru architektury procesora, warto kierować się specyficznymi potrzebami użytkowników oraz oczekiwaniami związanymi z wydajnością systemu.

Co to jest cykl instrukcyjny i jak działa?

Cykl instrukcyjny, zwany również cyklem rozkazowym, odgrywa kluczową rolę w działaniu procesora. Składa się on z pięciu głównych etapów, które w odpowiedniej kolejności pozwalają na wykonanie poleceń. Cały proces zaczyna się od:

- fazy pobrania rozkazu, w której instrukcja zostaje ściągnięta z pamięci operacyjnej,

- etapu dekodowania, w którym procesor analizuje zawarte w instrukcji operacje, co pozwala mu zrozumieć, co należy wykonać,

- fazy pobierania operandów, podczas której gromadzone są niezbędne dane do realizacji polecenia,

- fazy wykonania rozkazu, w której procesor realizuje zdefiniowaną operację, korzystając z danych zgromadzonych w rejestrach lub pamięci,

- zapisu wyniku, czyli umieszczenia rezultatu operacji w odpowiednim rejestrze bądź pamięci.

Cały mechanizm koordynowany jest przez układ sterowania i synchronizacji, który zapewnia płynne przejścia pomiędzy poszczególnymi fazami. Cykl instrukcyjny powtarza się dla każdej instrukcji w programie, co umożliwia efektywne wykonywanie bardziej skomplikowanych zadań obliczeniowych. W kontekście architektury komputerowej optymalizacja tego cyklu ma duży wpływ na ogólną wydajność systemu. Staranność w realizacji poszczególnych procesów jest niezbędna, aby uniknąć konfliktów w przetwarzaniu instrukcji, które mogłyby wpłynąć negatywnie na efektywność. W praktyce, różne badania oraz technologie, takie jak mikroprogramowanie czy potokowość, są wykorzystywane do udoskonalania cykli instrukcyjnych. Dzięki temu, następuje poprawa zarówno w zakresie wykorzystania energii, jak i w szybkości przetwarzania danych.